もくじ

GitHub ManageRds

ジョブサーバの

/root/manageRds

に設置したアプリを利用してバックアップを行うのが良いでしょう。

バックアップしているもの

- dumpファイル

- binlogファイル

S3のバケット作成

- {プロジェクト名}-backup-develop

- {プロジェクト名}-backup-staging

- {プロジェクト名}-backup-production

IAMの作成

Terraformで作成してください

ご参考

variable.tf

variable ENV_VALUE_ENVIRONMENT {}

variable ENV_VALUE_PROJECT_NAME {}

iam.tf

# S3へバックアップする為のユーザ

resource "aws_iam_user" "s3_sync" {

name = "s3-sync-${var.ENV_VALUE_ENVIRONMENT}"

# Accessキーの削除・更新ができるようにする

force_destroy = true

}

resource "aws_iam_policy" "s3_sync" {

name = "s3-sync-${var.ENV_VALUE_ENVIRONMENT}-policy"

policy = jsonencode({

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"s3:PutObject",

"s3:GetObject",

"s3:DeleteObject"

],

"Resource": [

"arn:aws:s3:::${var.ENV_VALUE_PROJECT_NAME}-backup-${var.ENV_VALUE_ENVIRONMENT}/*"

],

},

{

"Effect": "Allow",

"Action": [

"s3:ListBucket"

],

"Resource": [

"arn:aws:s3:::${var.ENV_VALUE_PROJECT_NAME}-${var.ENV_VALUE_ENVIRONMENT}"

]

}

]

})

description = "S3へファイルをアップロードする"

}

resource "aws_iam_user_policy_attachment" "s3_sync_policy_attach_s3_sync" {

user = aws_iam_user.s3_sync.name

policy_arn = aws_iam_policy.s3_sync.arn

}

# RDS モニタリング用

resource "aws_iam_role" "rds_monitoring_role" {

name = "rds-monitoring-role-${var.ENV_VALUE_ENVIRONMENT}"

assume_role_policy = file("${path.module}/policy/assume-rds.json")

}

resource "aws_iam_policy" "rds_monitoring_policy" {

name = "rds-monitoring-policy-${var.ENV_VALUE_ENVIRONMENT}"

policy = file("${path.module}/policy/rds-monitoring.json")

}

resource "aws_iam_role_policy_attachment" "rds_monitoring_role_attach_policy" {

role = aws_iam_role.rds_monitoring_role.name

policy_arn = aws_iam_policy.rds_monitoring_policy.arn

}

/policy/rds-monitoring.json

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "EnableCreationAndManagementOfRDSCloudwatchLogGroups",

"Effect": "Allow",

"Action": [

"logs:CreateLogGroup",

"logs:PutRetentionPolicy"

],

"Resource": [

"arn:aws:logs:*:*:log-group:RDS*"

]

},

{

"Sid": "EnableCreationAndManagementOfRDSCloudwatchLogStreams",

"Effect": "Allow",

"Action": [

"logs:CreateLogStream",

"logs:PutLogEvents",

"logs:DescribeLogStreams",

"logs:GetLogEvents"

],

"Resource": [

"arn:aws:logs:*:*:log-group:RDS*:log-stream:*"

]

}

]

}

RDSのパラメータグループ

resource "aws_rds_cluster_parameter_group" "xxx_db" {

name = "${var.console_db_identifier_prefix}-parameter-group-aurora8-${var.ENV_VALUE_ENVIRONMENT}"

family = "aurora-mysql8.0"

description = "Cluster parameter group"

parameter {

name = "character_set_client"

value = "utf8mb4"

apply_method = "immediate"

}

parameter {

name = "character_set_connection"

value = "utf8mb4"

apply_method = "immediate"

}

parameter {

name = "character_set_database"

value = "utf8mb4"

apply_method = "immediate"

}

parameter {

name = "character_set_filesystem"

value = "utf8mb4"

apply_method = "immediate"

}

parameter {

name = "character_set_results"

value = "utf8mb4"

apply_method = "immediate"

}

parameter {

name = "character_set_server"

value = "utf8mb4"

apply_method = "immediate"

}

parameter {

name = "collation_connection"

value = "utf8mb4_general_ci"

apply_method = "immediate"

}

parameter {

name = "collation_server"

value = "utf8mb4_general_ci"

apply_method = "immediate"

}

parameter {

name = "time_zone"

value = "Asia/Tokyo"

apply_method = "immediate"

}

# binlogのフォーマット設定 // Auroraのデフォルトはnullで指定することで有効化

parameter {

name = "binlog_format"

value = "MIXED"

apply_method = "pending-reboot"

}

# 最大接続数 アプリケーションサーバー台数 * 最大スレッド数 を見て調整するのがセオリー。特に台数の制御なくオートスケールするので最大にしておく

parameter {

name = "max_connections"

value = "16000"

}

# binlogを利用してリストアするのに必要

parameter {

name = "log_bin_trust_function_creators"

value = "1"

apply_method = "immediate"

}

# slow_queryの出力を有効化

parameter {

name = "slow_query_log"

value = "1"

apply_method = "immediate"

}

# 一般ログの出力を有効化

parameter {

name = "general_log"

value = "1"

apply_method = "immediate"

}

# slow_queryの閾値。この場合は1秒

parameter {

name = "long_query_time"

value = "1"

apply_method = "immediate"

}

# 監査ログ 有効化

parameter {

name = "server_audit_logging"

value = "1"

apply_method = "immediate"

}

# 監査ログ CloudWatch Logsへの出力

parameter {

name = "server_audit_logs_upload"

value = "1"

apply_method = "immediate"

}

# 監査ログ 監査させるIAM ROLE

parameter {

name = "aws_default_logs_role"

value = var.rds_monitoring_role_arn

apply_method = "immediate"

}

# 監査ログ イベント対象

parameter {

name = "server_audit_events"

value = "CONNECT,QUERY,QUERY_DCL,QUERY_DDL,QUERY_DML,TABLE"

apply_method = "immediate"

}

# デッドロックをエラーログに出力

parameter {

name = "innodb_status_output"

value = "1"

apply_method = "immediate"

}

parameter {

name = "innodb_status_output_locks"

value = "1"

apply_method = "immediate"

}

# 行データのデッドロック default: 50秒 -> 5秒

parameter {

name = "innodb_lock_wait_timeout"

value = "5"

apply_method = "immediate"

}

# idle timeout defalt: 28800 -> 600

parameter {

name = "wait_timeout"

value = "600"

apply_method = "immediate"

}

}

AWS CLIの設定

developの場合 # aws configure --profile s3-sync-develop AWS Access Key ID [None]: AKIARxxxxxxxxxxxxx AWS Secret Access Key [None]: xxxxxxxxxx Default region name [None]: ap-northeast-1 Default output format [None]: json stagingの場合 # aws configure --profile s3-sync-staging (略) productionの場合 # aws configure --profile s3-sync-production (略)

管理アプリのインストール

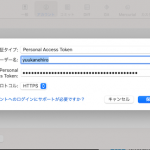

git cloneする

# git clone https://github.com/yuukanehiro/ManageRds.git # cd ManageRds

ウィザードを実行

# sh createProfile.sh

実行例

root@ip-172-xxx-xxx-242:~/ManageBinlog# sh createProfile.sh

DB接続の設定ファイル作成ウィザード Start

まずDBをダンプバックアップバッチを作ります。

プロジェクト名(サービス名)を教えてください。S3バケットの名前に使います。${PJ_NAME}-backup-${ENV}

sampleapp

環境を教えて下さい

develop/staging/production

staging

DBの接続先はreader(slave)ですか、それともwriter(master)かを教えて下さい。readerインスタンスとreaderエンドポイントが存在する場合はreaderをお勧めします。

reader/writer

reader

DBの名前を入力してください。例) sampledb

yuu3

DBのuser名を入力してください。例) admin

sampledb

DBのreader_endpoint(host)を入力してください。例) sample-db.cluster-ro-xxxxx.ap-northeast-1.rds.amazonaws.com

sampleapp-sampledb-staging-v1-1.cluster-ro-xxxxx.ap-northeast-1.rds.amazonaws.com

DBのpasswordを入力してください。例) p@sSw0rd

xxxxx

こちらで正しいですか?設定ファイルが既に存在する場合は上書きされます。

PJ_NAME:sampleapp

ENV:staging

READER_OR_WRITER:reader

DB_NAME:sampledb

DB_USER:yuu3

DB_HOST:sampleapp-sampledb-staging-v1-1.cluster-ro-xxxxx.ap-northeast-1.rds.amazonaws.com

DB_PASSWORD:xxxxx

----------------------------

yes/no

yes

./profiles/sampledb_reader.conf

MySQL接続ファイルを作成しました! ./profiles/sampleapp_reader.conf

----------------------------

DBダンプバッチを作成しました! ./batches/sampledb/dumpdb.sh

WriterインスタンスからbinlogをS3にバックアップするバッチを作成しますか?

yes/no

yes

DBのwriter_endpoint(host)を入力してください。例) sample-db.cluster-xxxxx.ap-northeast-1.rds.amazonaws.com

sampleapp-sampledb-staging-v1-1.cluster-xxxxx.ap-northeast-1.rds.amazonaws.com

./profiles/sampleapp_writer.conf

MySQL接続ファイルを作成しました! ./profiles/sampledb_writer.conf

----------------------------

binlogバックアップバッチを作成しました! ./batches/sampleapp/backupBinlogToS3.sh

バックアップ先のS3からbinlogをダウンロードするバッチを作成しますか?

yes/no

yes

DB接続の設定ファイル作成ウィザード End

ウィザード生成されるバッチファイル

- mysqldumpによるダンプデータをS3に退避するバッチ

dumpdb.sh - binlogをS3に退避するバッチ

backupBinlogToS3.sh - S3に退避されたbinlogをダウンロードするバッチ

downloadBinlogFromS3.sh

S3からdumpファイルを1つダウンロードする場合

stagingのdumpファイルをダウンロードする例

# s3 scp --profile s3-sync-staging s3://sampleapp-backup-staging/database/sampledb/dump/${DAY}/{ダンプファイル名} .

プロフィール情報を利用した接続

# mysql --defaults-extra-file=~/ManageRds/profiles/sampledb_staging_writer.conf

Cron設定

/etc/crontabファイルにて設定されています。

/etc/crontab

・・・ ## sample DB # DB binlog * * * * * root sh /root/ManageRds/batches/sampledb/develop_backupBinlogToS3.sh * * * * * root sh /root/ManageRds/batches/sampledb/staging_backupBinlogToS3.sh * * * * * root sh /root/ManageRds/batches/sampledb/production_backupBinlogToS3.sh # DB dump 00 * * * * root sh /root/ManageRds/batches/sampledb/develop_dumpdb.sh 00 * * * * root sh /root/ManageRds/batches/sampledb/staging_dumpdb.sh 00 * * * * root sh /root/ManageRds/batches/sampledb/production_dumpdb.sh

設定を行ったら反映させてください

# systemctl restart cron

監視設定

関連

binlogのリストアなどは下記をご参考にしてください。

- AWS RDS PITR+ロールフォワードによるリカバリ 【下準備編】

- AWS RDS PITR+ロールフォワードによるリカバリ 【汎用 RDSのディスク障害からの復旧】

- AWS RDS PITR+ロールフォワードによるリカバリ 【誤ったクエリ発行からの復旧】